AI und KI sind inzwischen Begriffe, die bei nahezu jedem Produkt zum Einsatz kommen. Meist wird dafür eine NPU genutzt. Doch was heißt das eigentlich und was macht eine NPU?

Ob man es will oder nicht, AI-Anwendungen sind im Kommen und breiten sich in allen Bereichen des digitalen Lebens aus. Das Thema ist vielschichtig und hochkomplex, wer daran interessiert ist, kann sich hier mehrere Wochen einlesen.

Für die Unterhaltungselektronik und die Endanwender*innen ist das Ganze einfacher: Über einen speziellen Chip namens NPU im Gerät (Smartphone, Notebook oder PC) kann eine KI-Software schneller Muster und komplexe Zusammenhänge berechnen. Dadurch können z.B. Elemente in Bildern schneller und zuverlässiger erkannt und bearbeitet werden, Vogelarten analysiert oder die Kommunikation mit technischen Geräten deutlich erleichtert werden.

DATENSCHUTZHINWEIS: Dieses Video ist im erweiterten Datenschutzmodus von YouTube eingebunden. Durch den Klick auf das Wiedergabesymbol willige ich darin ein, dass eine Verbindung zu Google hergestellt wird und personenbezogene Daten an Google übertragen werden, die dieser Anbieter zur Analyse des Nutzerverhaltens oder zu Marketing-Zwecken nutzt. Weitere Infos hier.

Aber warum gibt es dafür einen eigenen Chip? Und was ist daran so besonders, dass er neben normalen Prozessoren verbaut wird? Wurde das ganze KI-Zeug nicht mal von der GPU berechnet? Wir zeigen euch, was eine NPU ist und warum das Konzept dahinter so cool ist.

Inhaltsverzeichnis

Was ist eine NPU?

Die Abkürzung NPU steht für Neural Processing Unit und ist eine Art Prozessor. Während typische CPUs alles mögliche erledigen können und sollen, ist eine NPU hochspezialisiert, um AI-Aufgaben schnell und effizient lösen zu können. AI ist dafür nicht der einzige Begriff, es wird auch gerne von Künstlicher Intelligenz oder Machine Learning gesprochen.

NPUs sind dabei so spezialisiert, dass sie bis zu 10.000 mal schneller als GPUs bei AI-Berechnungen sein können. Sie setzen zudem stark auf Parallelisierung (ähnlich wie das Konzept hinter Multi-Tasking). Da sie aber so spezialisiert sind, werden sie meist neben normalen Prozessoren und GPUs genutzt, um diese zu entlasten.

Eine einheitliche Bauart bzw. Struktur gibt es derzeit für NPUs noch nicht. Jeder Chiphersteller setzt auf seine eigene Architektur, weshalb es derzeit noch Unterschiede bei den einzelnen NPUs gibt.

Geschichte der NPU

Die erste Erwähnung einer Art Neuronalen Prozessors geht zurück auf das Jahr 1988, als über die Implementierung von neuronalen Netzwerken zur optischen Erkennung des Alphabets gesprochen wurde. In den frühen 90ern hatte Intel bereits mit dem ETANN 80170NX und Ni1000 erste Prototypen dieser Art. Der gedachte Einsatzzweck waren hier eher Workstations und der wissenschaftliche Sektor.

So richtigen Erfolg – weil sich auch die Technik weiterentwickelt hat – gab es erst in den 2010er Jahren. So wurde 2014 ein Prozessor namens DianNao (Chinesisch für „Elektrisches Hirn“) vorgestellt, der bereits wie eine NPU funktioniert hat. Die Leistung wurde bei den Nachfolge-Modellen (DaDianNao, ShiDianNao, PuDianNao) noch deutlich verbessert. In Smartphones gab es die ersten AI-Beschleuniger 2018 mit dem Qualcomm Snapdragon 855.

Bereits 2012 hat man mit zwei GPUs versucht, ein neuronales Netzwerk (AlexNet) zum Laufen zu bringen. Und auch heute noch werden GPUs für gigantische bzw. industrielle AI-Systeme gerne genutzt. Im Supercomputer Summit von IBM im Oak Ridge National Laboratory stecken zum Beispiel 27.648 Nvidia Tesla V100 Grafikkarten.

Inzwischen kommt bei den meisten Endgeräten eine NPU zum Einsatz. Jedoch gibt es bei Grafikkarten inzwischen ebenfalls AI-Beschleuniger, bei Nvidia sind das zum Beispiel die Tensor-Kerne.

Sind NPUs besser als GPUs und CPUs?

Das hört sich alles sehr revolutionär an. Jedoch sind NPUs nur für gewisse Bereiche nutzbar, für generelle mathematische Berechnungen sind sie nur „naja“ einsatzfähig. Sie werden also normalen Prozessoren und Grafikkarten erstmal nicht gefährlich.

Bild: Nvidia

NPUs eignen sich zur Mustererkennung (z.B. Sprache, grundsätzliche Änderungen bei Bild/Video) und für sich wiederholende kleine Aufgaben. Sie profitieren dann auch von der starken Parallelisierung der NPU-Architektur, also eine Menge kleinerer repetitiver Aufgaben parallel abzuarbeiten.

Für komplexere Arbeiten kommen dann spezielle GPUs zum Einsatz. Aber auch handelsübliche GPUs mit NPU-Kernen (z.B. Tensor-Kerne) können solche komplexen KI-Aufgaben erfüllen. Es wird derzeit auch an sogenannten GPNPU (General Purpose NPU) gearbeitet, also ein Mittelweg zwischen NPUs und GPUs. Ob sich das Konzept aber wirklich durchsetzen wird, ist noch fraglich.

Neuronale Netzwerke in meinem Computer?

Es ist wahrscheinlicher als man denkt. Der aktuelle AI-Trend wird wohl eine ganze Weile anhalten und viele Anwendungen werden auf AI-Funktionen setzen. Daher werden wohl mehr Geräte in Zukunft mit einer NPU versehen. Bereits jetzt sind NPUs ein fester Bestandteil von Smartphones und allerlei Technik-Spielereien. Doch was ist eigentlich mit „normalen“ Computern und Notebooks?

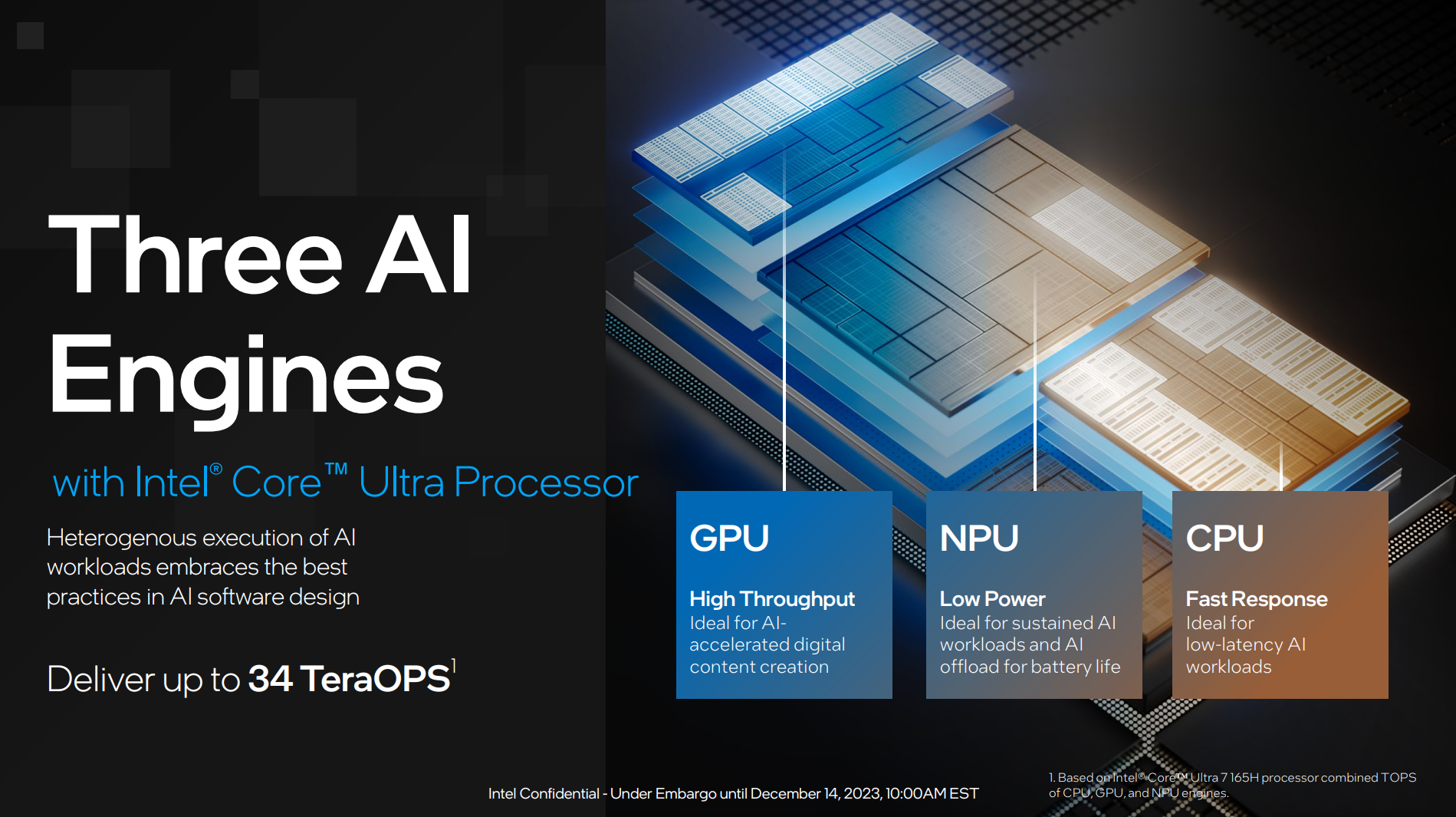

Bild: Intel

Auch an Intel und AMD sind neuronale Netzwerke nicht vorbeigegangen. Seit Januar 2024 ist eine NPU Bestandteil der neuen Ultra-Prozessoren (Meteor Lake). Die neuen Prozessoren haben einen „Chiplet“-Aufbau und sind nun deutlich modularer. AMD arbeitet derzeit aktiv an der zweiten Generation ihrer NPU mit dem Namen „XDNA 2“, welche 2024 in den kommenden „Strix Point“-Prozessoren zum Einsatz kommen soll.

Aber auch abseits von lokalen bzw. physischen NPUs nutzen immer mehr Anwendungen und Webseiten KI-Funktionen. Diese werden dann eben nicht lokal, sondern von einem Server berechnet und die Ergebnisse dann zur Anwendung geschickt. Man kommt in 2024 also eigentlich gar nicht mehr drum herum.

Fazit: Immer mehr AI-Funktionen, immer mehr NPUs

Nachdem der AI-Trend schon seit einigen Jahren vorhanden ist, findet nun spezielle Hardware in Form von NPUs Einzug in unsere Geräte. Bei Smartphones ist ein Wandel hin zu mehr AI bereits in vollem Gange ist, auf Notebooks und Computern beginnt er erst so richtig im Jahr 2024. Deshalb sind die Vorteile dort derzeit noch überschaubar.

Die Entwicklung von passender AI-Software (z.B. Bildbearbeitung von Adobe, Videobearbeitung von Davinci Resolve usw.) wird Hand in Hand mit der Entwicklung von NPUs gehen. Was genau dabei herauskommt, ist noch nicht klar absehbar.

Bei Spielen geht der Trend hin zu ressourcensparenden AI-Techniken wie DLSS von Nvidia oder XFS von AMD. Es tauchen bestimmt aber auch bald Funktionen direkt in Spielen auf, wie etwa deutlich smartere Gegner oder aktiv und spontan generierte Dialoge.

Zu guter Letzt binden auch Hersteller von Betriebssystemen (z.B. Microsoft Windows, Google Android usw.) immer mehr AI-Funktionen ein. Die darunterliegenden Technik-Schnittstellen werden in den kommenden Jahren ebenfalls weiterentwickelt. Im Grunde werden wir – bei egal welcher Soft- und Hardware – in den kommenden Monaten und Jahren große Sprünge in Sachen KI bzw. neuronale Netzwerke sehen.

Wer mehr darüber erfahren will, kann sich folgende YouTube-Videos dazu ansehen. Diese gehen mehr ins Detail und zeigen Beispiele:

– How neuromorphic computing will change our world in wonderful ways | Intel

– What is a Neural Network? | How Deep Neural Networks Work | Neural Network Tutorial | Simplilearn

– Neural Networks Explained in 5 minutes | IBM Technology

– Meteor Lake: AI Acceleration and NPU Explained | Talking Tech | Intel Technology

– Architecture All Access: Meteor Lake – Artificial Intelligence | Intel Technology

Prozessoren bei uns im Shop

Quelle: Wikipedia – Neuromorpher Prozessor, Wikipedia – AI accelerator